Auf Youtube ist die Erde eine Scheibe

Die Aufregung um den Datenskandal bei Facebook könnte leicht vergessen machen, dass auch Google ein Glaubwürdigkeitsproblem hat. Deren Video-Plattform Youtube steht vermehrt als Katalysator für problematische Inhalte wie Hassbotschaften und Verschwörungstheorien in der Kritik.

In anderen, früheren Zeiten wäre Mike Hughes ein Spinner gewesen, ein Freak, der bestenfalls eine kleine Schar Gleichgesinnter um sich versammelt hätte. Heute ist Hughes ein Superstar. Nicht trotz, sondern wegen seiner Obsession, den Beweis erbringen zu wollen, dass die Erde eine Scheibe ist. Mit einer selbstgebastelten Rakete will er von oben nachsehen, ob das wirklich stimmt. Auf Youtube schaut ein Millionenpublikum dem Treiben von «Mad Mike» zu. Und vielleicht hegt der eine oder andere Zweifel an der Kugelgestalt unseres Planeten und hält die Scheibentheorie für zumindest bedenkenswert.

Die Techniksoziologin Zeynep Tufekci hat in der «New York Times» die These aufgestellt, dass Youtube einer Radikalisierung der Gesellschaft/der Menschen im Netz Vorschub leiste. Die Wissenschaftlerin hatte während des US-Präsidentschaftswahlkampfs 2016 beobachtet, dass Youtube ihr nach dem Abrufen von Videos über Trump-Kundgebungen Videos über weisse Rassisten und Holocaust-Leugner vorschlug und diese automatisch abspielte. Tufekci, die keine rechtsextremen Kanäle abonniert hat, wollte wissen, ob es sich dabei um ein genuin rechtes bzw. milieuspezifisches Phänomen handelt. Also legte sie einen neuen Kanal an und schaute Videos über Hillary Clinton und Bernie Sanders. Youtubes Algorithmus leitete sie prompt auf Videos über linke Verschwörungstheoretiker weiter. Auch bei unpolitischen Inhalten beobachtete die Soziologin einen Radikalisierungseffekt. Clips über Vegetarier führten zu Clips über Veganer. Videos über Joggen zu Ultramarathons. Man surft von einem Extrem ins nächste.

Youtube will seine Nutzer durch das Ausspielen von hyperpersonalisiertem Content möglichst lange bei der Stange halten.

Aus diesen Beobachtungen leitete die Wissenschaftlerin ab, dass Youtubes Algorithmus nach einer Extremismus-Logik operiert. «Vor dem Hintergrund der Milliarden Nutzer könnte Youtube eines der mächtigsten Radikalisierungswerkzeuge des 21. Jahrhunderts sein.» Der Vorwurf: Die Softwareingenieure hätten den Algorithmus so justiert, dass er den Furor seiner Nutzer künstlich anfache. Diese Mechanik liegt im Geschäftsmodell der Videoplattform begründet. Youtube will seine Nutzer durch das Ausspielen von hyperpersonalisiertem Content möglichst lange bei der Stange halten. Denn je länger die Nutzer Videos anschauen, desto mehr Geld verdient Google. Die Radikalisierung ist sozusagen nur ein Nebeneffekt der Aufmerksamkeitsökonomie, aber ein umso gravierender, weil durch den Mechanismus radikale Ansichten von Nutzern verstärkt oder sogar produziert werden können.

Nun kann man die Frage stellen, ob man aus der Eigenempirie wissenschaftlich belastbare Zusammenhänge herstellen kann. Nur weil die Soziologin Tufekci bei ihrem Nutzungsverhalten einen Radikalisierungseffekt erkannt haben will, muss das nicht für alle Youtube-Nutzer gelten. Eine Gesetzmässigkeit lässt sich mithin noch nicht identifizieren. Plausibel wäre die Erklärung, dass Youtube Inhalte in Abhängigkeit der Google-Suchhistorie ausspielt. Zumindest merkt sich der Dienst, an welcher Stelle man ein Video beendet hat, wenn man mit seinem Gmail-Account angemeldet ist. Diese Komplexität der Datenzusammenführung kommt in Tufekcis Analyse etwas zu kurz. Für eine profunde wissenschaftliche Untersuchung, hier ist Tufekci zuzustimmen, fehlt jedoch die Datengrundlage – Google gibt ebenso wenig wie Facebook seine Daten zu wissenschaftlichen Zwecken frei. Die Forschung ist daher auf Mutmassungen oder empirisch wenig unterfütterte Theorien angewiesen.

Das alles kontrastiert mit dem Bild des vermeintlichen «Saubermanns» Google.

Man muss jedoch keinen Radikalisierungseffekt nachweisen, um eine generelle Radikalität von Youtube zu konstatieren. Enthauptungsvideos, Hassbotschaften, Aufrufe zur Gewalt – auf dem Videoportal wimmelt es nur so von extremistischen Inhalten. Das alles kontrastiert mit dem Bild des vermeintlichen «Saubermanns» Google, dessen erklärtes Ziel es ist, «die Informationen der Welt zu organisieren und für alle zu jeder Zeit zugänglich und nutzbar zu machen». Der Islamische Staat nutzt den Videodienst gezielt als Propaganda-Werkzeug und Rekrutierungskanal. Neonazis und notorische Holocaust-Leugner verbreiten antisemitische Hasspropaganda. Und auf dem Kinderkanal YouTube Kids waren Gewalt- und Sex-Szenen zu sehen im Stil beliebter Trickfilm-Serien.

Youtube hat einige Gegenmassnahmen getroffen. So blockiert und löscht der Dienst automatisch gewaltverherrlichende Inhalte und leitet Nutzer, die nach dem IS suchen, mit der Redirect Method gezielt um. Mit einer Mischung aus menschlicher und künstlicher Intelligenz will Youtube der Verbreitung von Hassvideos zu Leibe rücken. Unter dem Druck nationaler Regierungen kündigte die Plattform im vergangenen Jahr an, die Zahl seiner für die Löschung von extremistischen Inhalten zuständige Abteilung auf 10’000 Mitarbeiter aufzustocken. Youtube hat kürzlich ein Update seiner Kinder-App Kids bereitgestellt, mit dem Eltern in den Einstellungen die algorithmische Weiterempfehlungsfunktion deaktivieren können. Gleichzeitig experimentiert der Dienst mit Warn- und Informationshinweisen («information cues»), die bei verschwörungstheoretischen Videos wie der Mondlandung oder Chemtrails eingeblendet werden und auf Wikipedia-Artikel verlinken.

Youtube funktioniert ganz nach den Gesetzmässigkeiten der digitalen Aufmerksamkeitsökonomie.

Doch ob man damit die Verbreitung von Gewaltvideos und Verschwörungstheorien eindämmen kann, ist fraglich. Dass eine Video-Plattform Nutzer auf textbasierte Informationen verweist und darauf hofft, dass sich für Verschwörungstheorien empfängliche Nutzer durch die Lektüre von Wikipedia-Einträgen von ihren kruden Ansichten abbringen lassen, ist einigermassen naiv. Youtube funktioniert ganz nach den Gesetzmässigkeiten der digitalen Aufmerksamkeitsökonomie: Wo man sich in einer deliberativen Demokratie mit Argumenten Gehör verschaffen muss, reicht in den Echokammern von Youtube der grosse Knall, um Aufmerksamkeit zu erzeugen. Youtube basiert auf einem algorithmischen Popularitätsvoting: Es prämiert die Erzählungen, die am meisten geklickt werden. So lässt sich mit dem antiaufklärerischen Narrativ, die Erde sei eine Scheibe, viel Geld verdienen. Was zählt, ist nicht der objektive Wahrheitsgehalt, sondern die Zahl der Klicks, der Währung im medialen Ökosystem von Youtube. Algorithmen sind dabei der Brandbeschleuniger, durch den sich Unwahrheiten und Verschwörungstheorien wie ein Lauffeuer im Netz verbreiten.

Nach dem Attentat in Las Vegas im Oktober 2017, bei dem 58 Menschen getötet und 851 weitere verletzt wurden, poppten auf Youtube reihenweise Videos auf, die dem Attentäter eine Agententätigkeit andichteten oder mit fragwürdigen Beweisen Zweifel an dem Tathergang säen wollten. Auch 48 Stunden nach den tödlichen Schüssen tauchten derlei verschwörungstheoretische Videos auf. Das weckt freilich den Verdacht, dass Youtubes Filtermechanismen entweder nicht richtig funktionieren oder die Schleusen absichtlich offen gelassen werden, weil sich mit kruden Inhalten mehr Anzeigengeld verdienen lässt als mit seriösen Erklärvideos.

Das betriebswirtschaftliche Kalkül, Klick-heischenden Content zu pushen, könnte sich langfristig als Hypothek für die digitale Öffentlichkeit erweisen.

Die Videoplattform erweist sich immer mehr als Katalysator für Verschwörungstheorien und Hassbotschaften, die dem erklärten Ziel der Mutterfirma Google, «die Informationen der Welt zu organisieren und für alle zu jeder Zeit zugänglich und nutzbar zu machen», zuwiderlaufen. Das betriebswirtschaftliche Kalkül, Klick-heischenden Content zu pushen, könnte sich langfristig als Hypothek für die digitale Öffentlichkeit erweisen, weil über das kurzweilige Vergnügen beim Aufrufen eines Youtube-Videos ein algorithmisches Denken Raum greift, das suggeriert, dass der Lauf der Dinge gewissermassen programmiert sei. Diese Logik macht wiederum rezeptiv für deterministische Weltanschauungen. Denn wer auf Youtube nach Videos zum Islam sucht und dabei islamistische Hassprediger angezeigt bekommt, muss annehmen, dass eine Religion automatisch in Extremismen mündet.

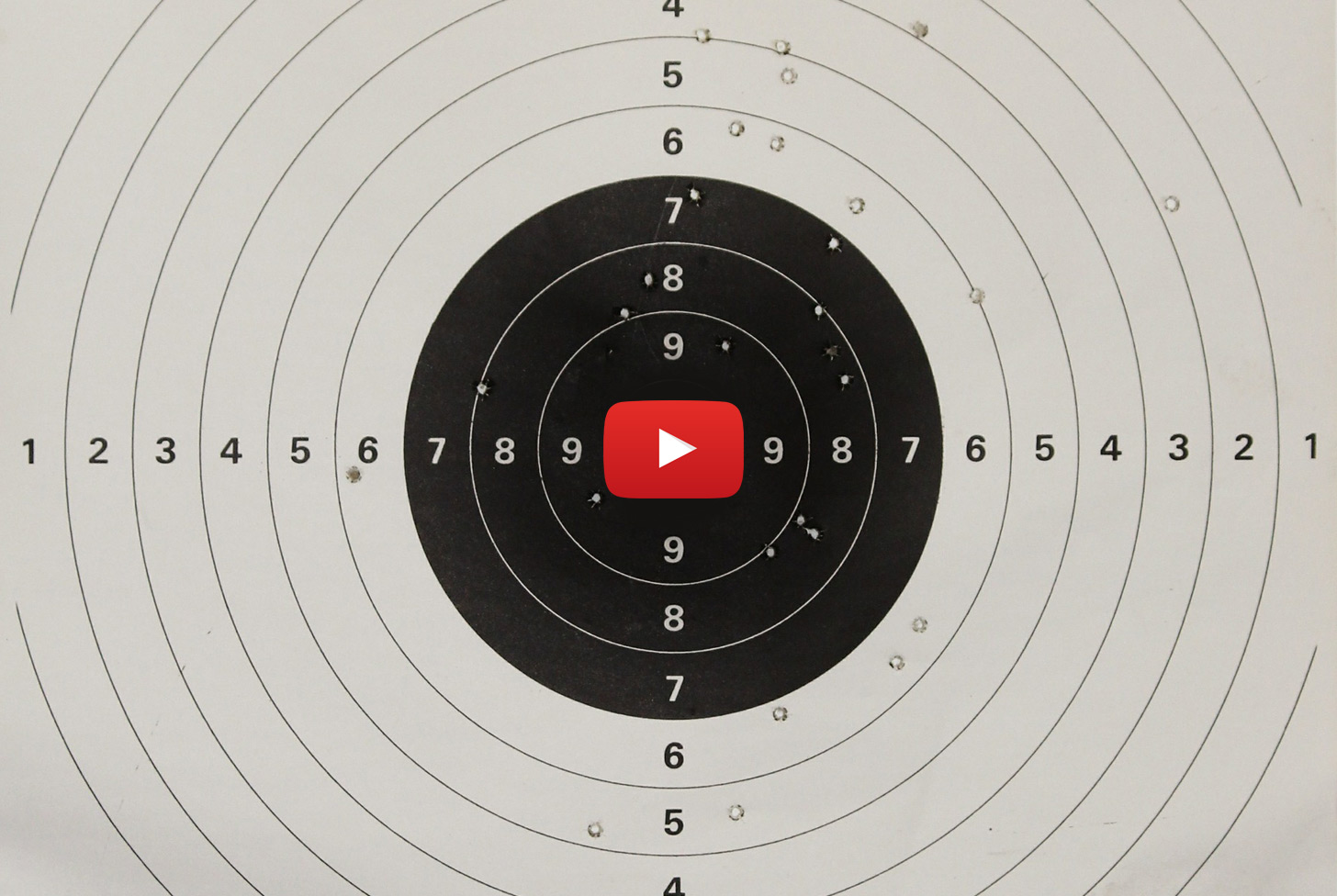

Wie weit die Radikalisierung gehen kann, zeigt sich bei der Schiesserei in der YouTube-Zentrale in San Bruno, bei der die Amokläuferin, eine vegane Aktivistin, mutmasslich wegen sinkender Klickzahlen und des Vorwurfs der Zensur das Feuer eröffnete. Die These, wonach Youtube, die Gewalt, die es sät, nun erntet, wäre gewiss zynisch und wohl selbst im Bereich der Verschwörungstheorie. Doch offenbart sich hier eine direkte Verbindungslinie zwischen einer Frau, die sich auf Youtube als militante Tierschutzaktivistin inszenierte und damit im Iran zum viralen Hit wurde, und einem Konzern, der ihr die Bühne gab – und am Ende selbst zur Zielscheibe wurde. An diesem Beispiel wird einmal mehr deutlich, dass es für soziale Probleme keine technische Lösung wie eine Änderung des Algorithmus, sondern nur eine soziale Antwort geben kann. Und die lautet: miteinander reden. Algorithmen können keine Konflikte moderieren, im Gegenteil, sie scheinen die Konfliktträchtigkeit zu verstärken. Doch solange Youtube an seinem Werbemodell festhält und Filterblasen konstruiert, wird sich das Publikum weiter polarisieren und radikalisieren – zum Schaden der Demokratie.

Chris H. 13. April 2018, 07:44

Danke für diesen Artikel. Lesens- und bedenkenswert.

Habnix 15. April 2018, 09:29

Ja es gibt Menschen die haben noch nie den Mond gesehen und nicht bemerkt das der Mond eine Kugelgestalt hat. Wie sollten sie da wissen das die Erde den selben Gesetzmäßigkeiten des Universum unterliegt.

Herrmann 17. April 2018, 03:28

Der Artikel ist auf so vielen Ebenen unterirdisch, vom fachlichen meine ich. Das Problem mit so vielen Neo-Pragmatikern ist, dass sie selbst nicht wissen, dass sie welche sind, aber dann trotzdem versuchen logische Semantik zu benutzen.

Und dieser, völlig wild mit Wörtern wie Determinismus und Logik, die er nicht versteht, um sich werfende Autor, will mir jetzt erzählen, was ich schauen darf und was nicht? Der Artikel ist so was von voll von Widersprüchen, es ist unglaublich.

Nebenbei, ohne Determinismus, Algorithmen und Logik hätte der Rechner und die darauf laufenden Prozesse den womöglich nicht ganz so logischen Text des Autors nicht verarbeiten können. Womöglich, sollte er diesen die Arbeit erledigen lassen. Ein simpler Algorithmus, der pseudo-zufällig Worte aus einem Wörterbuch zusammenwürfelt würde zumindest nur Unsinn erzeugen. Der Mensch dagegen, kann leider auch Gegensinn erzeugen.

„Diese Logik macht wiederum rezeptiv für deterministische Weltanschauungen.“

Oh, ehrlich? Wie rezeptiv? Und was macht diese, oder eine andere, Logik bei einer nicht deterministischen Weltanschauung? Es würde mich nicht wundern, wenn der Autor nicht genau wüsste, was eine Logik ist. Oder Determinismus, usw. – nur bei einer Logik liegts ja eben schon in der Sache selbst …

Muhammed 02. Mai 2018, 15:42

Dieser Artikel richtet sich ganz klar gegen die Meinungsfreiheit. „Meinungsfreiheit ja, aber nur da wo es mir/uns passt“