Internet killed the headline oder wenn Textautomaten für Suchmaschinen schreiben

Künstliche Intelligenz hält vermehrt in Redaktionen Einzug. Algorithmen schreiben nicht nur ganze Texte, sondern generieren auch Überschriften und Schlagwörter. Das schafft bessere Vernetzung und Sichtbarkeit. So kann etwa datengetriebener Journalismus helfen, unterschiedliche Lesertypen besser zu adressieren. Doch die Spielregeln bestimmen massgeblich Google und Facebook.

Journalisten kennen das Problem: Man hat einen Text geschrieben und grübelt an einer passenden Überschrift. Die Titelei ist nicht l’art pour l’art. Eine gute Überschrift framt den Text, gibt ihm einen Kontext und einen Dreh – und sticht dem Leser ins Auge. Gerade im Online-Journalismus, wo man Artikel schnell wegklickt oder wegwischt, ist ein griffiger Titel von elementarer Bedeutung. Auch, weil Algorithmen anhand der Titel entscheiden, was in den Schaufenstern von News-Aggregatoren wie Google News oder Facebook Newsfeed prominent erscheint. Für Medienunternehmen wollen in der Flut von Bildern und Artikeln sichtbar bleiben. Ein guter Titel, der viele Klicks bringt, ist im Wettbewerb mit anderen Medien ein geldwerter Vorteil. Der Anreiz, technische Hilfsmittel bei der Titelwahl einzusetzen, wird daher immer grösser.

Datenwissenschaftler von Axel Springer haben im vergangenen Jahr gemeinsam mit Amazon Web Services (AWS) eine Browser-Erweiterung namens «DeepTitle» als Instrument für die automatische Titelei entwickelt. Auf der Grundlage eines Artikels schlägt «DeepTitle» suchmaschinenoptimierte Schlagwörter und mögliche Titel vor. Wie in einem Paper von Axel Springer und Amazon Web Services nachzulesen ist, extrahiert die Software aus dem Text Stichwörter und errechnet für jedes ein erwartetes Suchvolumen. Der Journalist kann dann einen Titelvorschlag durch Anklicken übernehmen, zum Beispiel: «Airbus-Chef: A380 wurde zehn Jahre zu früh eingeführt». Man sieht diesem Titel nicht an, dass er maschinengeneriert ist. Er könnte genauso gut von einem menschlichen Redaktor stammen. Doch dahinter steckt eine Menge computergestützter Rechenleistung.

NLP gilt als das nächste grosse Ding im Journalismus. Die Technik kommt schon heute zum Einsatz, um bei investigativen Recherchen grosse Datenmengen aufzubereiten.

«DeepTitle» arbeitet mit Künstlicher Intelligenz und wurde mit 17‘000 Artikeln trainiert. Im Kern basiert «DeepTitle» auf Natural Language Processing NLP, einem Teilbereich der Künstlichen Intelligenz, der sich mit der Verarbeitung natürlicher Sprache beschäftigt. Als Blaupause diente dazu das von Google entwickelte Sprachmodell BERT, das seit geraumer Zeit bei der Analyse von Suchbegriffen eingesetzt wird.

Unterstützen Sie unabhängigen und kritischen Medienjournalismus. Werden Sie jetzt Gönner/in.

Journalismus braucht Herzblut, Zeit – und Geld. Mit einem Gönner-Abo helfen Sie, unseren unabhängigen Medienjournalismus nachhaltig zu finanzieren. Ihr Beitrag fliesst ausschliesslich in die redaktionelle und journalistische Arbeit der MEDIENWOCHE.

NLP gilt als das nächste grosse Ding im Journalismus. Die Technik kommt schon heute zum Einsatz, um bei investigativen Recherchen grosse Datenmengen aufzubereiten. Die Analysesoftware Parse.ly hat ein Tool entwickelt, das mithilfe von NLP Nachrichtenartikel nach vordefinierten Kategorien wie Politik oder Tech sortiert. Auch die Datenwissenschaftler von Axel Springer hatten sich einiges von der Technik erhofft. «Deep Title» wurde im Frühjahr vergangenen Jahres fertiggestellt, am Ende aber für nicht praxistauglich erachtet.

Erste Testläufe mit Journalisten hätten «gemischte Ergebnisse» geliefert, wie die am Projekt beteiligte Datenwissenschaftlerin und Co-Autorin Sarah Lück auf Anfrage mitteilt. «Die automatisch generierten Titel waren zu oft fehlerhaft und bedurften quasi immer einer Nachbearbeitung.» Dagegen sei die mitgelieferte Stichwort-Liste zusammen mit dem erwarteten Search-Traffic hilfreicher gewesen. Es hätte aber noch «mehrere Entwicklungsrunden» geben müssen, damit das Programm für Journalisten benutzbar gewesen wäre, so Lück.

Dass Axel Springer selbst mit Amazon-Unterstützung kein Durchbruch gelang, zeigt, dass NLP ein äusserst anspruchsvolles Forschungsfeld ist.

Dass das Projekt im ansonsten digitalaffinen Hause Axel Springer nicht weiterverfolgt wurde, lässt darauf schliessen, dass sich die Technik betriebswirtschaftlich noch nicht rechnet bzw. bis zur Marktreife noch weitere Forschungsgelder fliessen müssten. In den USA gibt es andere Möglichkeiten. So hat die «Washington Post» nach der Übernahme durch Amazon-Gründer Jeff Bezos ein eigenes Content-Management-System namens Arc aufgebaut, das neben Instrumenten für Layout und Storytelling unter anderem auch die semantische Indexierung und Verschlagwortung von Inhalten umfasst. Mit der Lizenzierung der Produktpalette generiert die «Washington Post» laut «Bloomberg» jährlich 100 Millionen Dollar. Zu den Lizenznehmern gehören unter anderem der «Boston Globe» und «Le Parisien».

Mit der Entwicklung solcher Hilfsinstrumente können Verlage viel Geld verdienen. Bloss: Nicht jedes Medienhaus hat ein so grosses Produktteam wie die «Washington Post» und kann sich auch mal Fehlschläge erlauben. Dass Axel Springer selbst mit Amazon-Unterstützung kein Durchbruch gelang, zeigt, dass NLP ein äusserst anspruchsvolles Forschungsfeld ist. Es geht nicht darum, Textbausteine aus Rohdaten nach einer vorgegebenen Matrix zu kohärenten Texten zusammenzubauen (so wie es bei der algorithmischen Erstellung von Meldungen im Börsen- und Sportjournalismus seit Jahren Praxis ist), sondern darum, ein semantisches Textverständnis zu entwickeln: Die Maschine muss lernen, was die Quintessenz in einem Text ist. Was man Schülern in jahrelangem Unterricht einbimst, kann man Algorithmen nicht in ein paar Tagen beibringen – so gross ihre Rechenpower auch sein mag. Doch darin liegt auch das Potenzial der Technik: Automatisch generierte Titel könnten nicht nur Ressourcen sparen und Kapazitäten für die Redaktionen freisetzen, sondern auch eine bessere Reichweite im Netz erzielen.

Der «Guardian» hat bereits 2015 unter der Ägide seines damaligen Digitalchefs Wolfgang Blau mit automatischer Verschlagwortung experimentiert. «Ein Problem bei manueller Verschlagwortung ist ja, dass Journalistinnen und Journalisten, entweder in der Eile oder weil das CMS zu unhandlich ist, die Verschlagwortung ganz versäumen oder nur ein statt mehrerer Schlagworte aussuchen oder – selten – sogar das falsche Schlagwort wählen», erklärt Blau auf Anfrage der MEDIENWOCHE. Die korrekte Verschlagwortung, sagt Blau, sei dabei nicht nur für die bessere Auffindbarkeit eines neuen Textes durch Suchmaschinen wichtig, sondern noch für eine ganze Reihe anderer Funktionen.

«Kaum eine Redaktion könnte es sich finanziell leisten, ältere Texte regelmässig manuell mit neuen Links zu aktuelleren Texten zu verlinken.»

Wolfgang Blau

«Nehmen wir einmal an, eine Leserin landet via Suchmaschine auf einem zwei Jahre alten, aber immer noch relevanten Text zum Thema Klimakrise und Landwirtschaft. Eine bewährte Methode, dieser Leserin dann weiterführende, neuere Artikel zu diesem Themenkomplex zu empfehlen, ist es, Links zu Texten mit der gleichen oder ähnlichen Kombination von Schlagwörtern im aufgefundenen Text anzuzeigen. Kaum eine Redaktion könnte es sich finanziell leisten, diese älteren Texte regelmässig manuell mit neuen Links zu aktuelleren Texten zu verlinken.» Ein weiterer Nutzen präziser Schlagworte sei die Erstellung oder zumindest Vor-Erstellung thematischer Newsletter, so Blau. Auch für die Erstellung der Artikel-URL sei es «aus SEO-Gründen hilfreich», wenn das Redaktionssystem dabei auf präzise ausgewählte Schlagworte zurückgreifen könne, die dann in der URL vorkommen.

«Mich stört es zum Beispiel schon seit Jahren, dass wir komplexe Themen stets so präsentieren, als ob alle Leserinnen und Leser die gleichen Vorkenntnisse davon hätten.»

Wolfgang Blau

Blau, der den «Guardian» 2015 verliess und danach fünf Jahre lang als Top-Manager des Medienkonzerns Conde Nast, zuletzt als Global Chief Operating Officer, gearbeitet hat, ist derzeit Gastforscher beim Reuters-Institut der Universität Oxford. Die Erfahrungen von Redaktionen im Umgang mit automatischer Verschlagwortung und der automatischen Erstellung von Vorschlägen für die Betitelung sieht er heute als wichtige Vorstufe zum journalistisch und ethisch ‹trittsicheren› Umgang mit anderen algorithmisch erzeugten Elementen im Redaktionsalltag.

«Für Journalisten ist die Vorstellung, Inhalte algorithmisch zu erzeugen oder auch nur anzureichern, zunächst einmal bedrohlich. Schon die Idee weckt nicht nur die Angst vor Arbeitsplatzverlust, sondern berechtigterweise auch die Angst vor der schwer nachweisbaren Manipulation von Inhalten», sagt Blau. «Bei vielen neuen Technologien denken wir aber nur reflexhaft darüber nach, wie diese auf bereits bekannte manuelle Arbeitsabläufe angewandt werden könnten, statt uns zu fragen, welche bisher undenkbaren oder zumindest bisher nicht finanzierbaren Produkte oder Dienstleistungen für unsere Leser damit möglich werden.»

Blau vermisst eine differenzierte Herangehensweise an bestimmte Themen, die auch das unterschiedliche Vorwissen der Rezipienten berücksichtigt: «Mich stört es zum Beispiel schon seit Jahren, dass wir komplexe Themen – etwa die Berichterstattung zu einer Steuerreform oder zur Klimakrise – stets so präsentieren, als ob alle Leserinnen und Leser in etwa die gleichen Vorkenntnisse zu diesem Thema hätten. Man kann diese Grundannahme als egalitär verteidigen, in der Konsequenz ist sie aber eher elitär. Eigentlich ist dieser One-size-fits-all-Ansatz auch nur ein Überbleibsel aus dem Industriezeitalter und den Limitierungen früherer Medientechnologien wie Print und linearem Broadcasting geschuldet.» Datengetriebener Journalismus könnte helfen, unterschiedliche Lesertypen besser zu adressieren, findet der Publizist. «Wäre es wirklich so bedrohlich oder ‹unjournalistisch›, dieselbe sauber recherchierte Nachricht in verschieden umfänglichen Versionen mit mehr oder weniger vorbereitendem Kontext anbieten zu können und diese Anpassung an verschiedene Lesertypen softwaregestützt und in Echtzeit vornehmen zu können?»

Wie soll ein Algorithmus wissen, ob etwas relevant oder im öffentlichen Interesse ist?

Doch die zunehmende Automatisierung redaktioneller Aufgaben wirft auch ethische Fragen auf. Wie geht ein Algorithmus mit einer Polizeimeldung um, in der die Nationalität des Täters genannt wird? Wird das prominent im Titel hervorgehoben, weil es viele Leute gibt, die das klicken würden? Oder wird die Information aus der Titelzeile verbannt? Wie soll ein Algorithmus wissen, ob etwas relevant oder im öffentlichen Interesse ist? Oder etwas grösser gefragt: Wie schreibt man den Pressekodex in den Software-Code?

Klar, am Ende drückt noch immer ein Mensch auf einen Knopf und steuert den Publikationsprozess. Aber was ist, wenn ein A/B-Test die reisserischere Titelvariante empfiehlt, weil sie besser geklickt wird? Wie weit darf Suchmaschinenoptimierung gehen? Erhöht Künstliche Intelligenz die journalistische Qualität oder produziert sie doch nur mehr Clickbait? Was schon heute klar ist: Google und Facebook definieren mit ihren Algorithmen, wie ein Artikel auszusehen hat, damit sie ihn auf ihren Plattformen prominent anzeigen.

Das Thema Algorithmen-Ethik scheint in den Verlagen noch nicht die Bedeutung zu haben, die es eigentlich bräuchte. Denn die Gefahr, dass Medien ein bestimmtes Wording bedienen, um mit ihren Artikeln in den Suchergebnissen weit oben zu erscheinen, ist gross. Natürlich haben Medien auch schon in der analogen Zeit versucht, mit reisserischen Titeln Aufmerksamkeit zu erzeugen und ihre Sichtbarkeit zu erhöhen, weshalb Effekthascherei kein alleiniges Strukturmerkmal digitaler Öffentlichkeiten ist. Dennoch folgt die digitale Aufmerksamkeitsökonomie einer anderen Logik, weil Artikel nicht mehr allein von Menschen gelesen, sondern von Maschinen verarbeitet und – je nachdem prominent – weiterverbreitet werden.

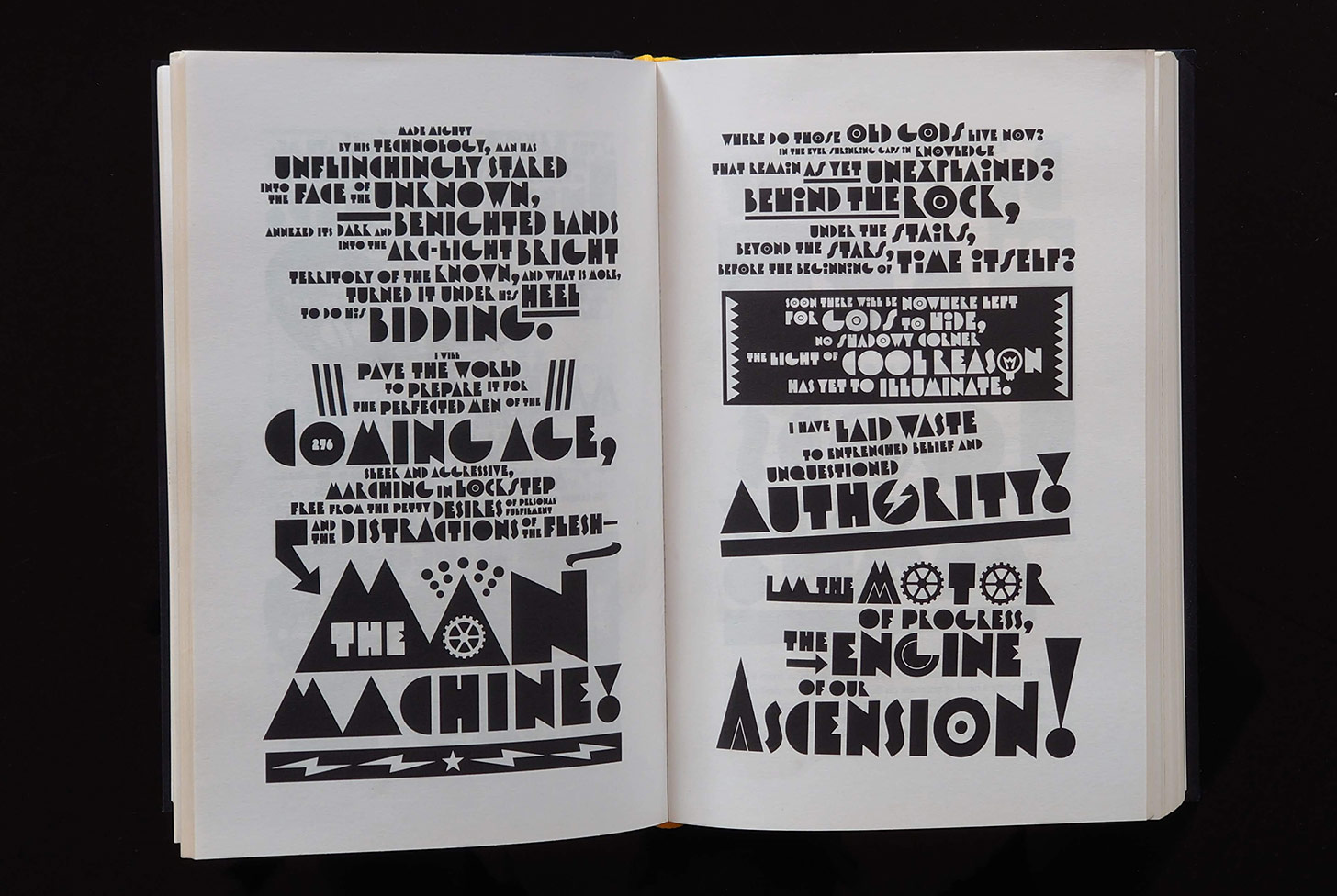

Ironische Schlagzeilen, wie sie sich etwa die «taz» oder der «Canard enchaîné» zum Markenzeichen gemacht haben, funktionieren im Digitalen weniger. Algorithmen verstehen bekanntlich keinen Spass. Mit der suchmaschinenoptimierten Titelei, die sich zunehmend der Werbesprache des Internets andient, droht somit auch ein Kulturverlust, schliesslich operieren Newsfeed- oder Suchmaschinenalgorithmen nicht nach ästhetischen, sondern nach rein ökonomischen Kriterien. Der Kolumnist und Pulitzerpreisträger Gene Weingarten hat diesen Mechanismus vor einigen Jahren ad absurdum geführt, indem er seine Kolumne in der «Washington Post» mit dem Meta-Titel «Gene Weingarten column mentions Lady Gaga» überschrieb. Das Schreiben von Headlines sei früher eine Kunst gewesen, so Weingarten. Jetzt sei es etwas Glanzloses, Utilitaristisches.