Wir haben die Kontrolle über unser Gesicht und unsere Stimme verloren

Photoshop war gestern, Bildmanipulation nur ein Vorgeschmack. Jetzt lassen sich auch bewegte Bilder und die menschliche Stimme «fernsteuern». Die Integrität der Information wird damit nachhaltig korrumpiert.

Im Online-Forum Reddit wurde vor ein paar Wochen ein Pornoclip eingestellt, in dem eine Michelle Obama verblüffend ähnlich aussehende Frau in Reizwäsche vor einem roten Sofa strippt. Doch bei dem Filmchen handelte es sich nicht etwa um eine geleakte Sexszene aus dem Weissen Haus, sondern um einen Fake.

Mithilfe einer Software namens FakeApp wurde das Gesicht der einstigen First Lady auf jenes einer Pornodarstellerin montiert und in einen Pornofilm integriert. Bei genauem Hinsehen erkennt man die rauen Bildübergänge und das kastenförmige Gesicht der Obama-Doppelgängerin.

Der Clip ist mittlerweile aus Reddit entfernt worden (auf einigen nicht jugendfreien Seiten ist er weiter abrufbar).Auf Pornoseiten im Web finden sich dutzende Clips, in denen Darstellerinnen mit den Gesichtern prominenter Schauspielerinnen wie Emma Watson oder Jennifer Aniston in auftauchen.

Solche computergenerierten Bilder waren bis vor ein paar Jahren lediglich in aufwendigen Hollywood-Produktionen möglich. Doch mit der Entwicklung und Popularisierung künstlicher Intelligenz benötigt man selbst für die Manipulation von Videosequenzen keine teure Hard- und Software mehr, sondern nur noch eine App. Ein Reddit-User demonstrierte kürzlich, wie einfach es ist, ein Video zu verfälschen. Der Nutzer mit dem bezeichnenden Pseudonym «deepfakes» nahm ein Foto der israelischen Schauspielerin Gal Gadot und platzierte es mithilfe eines Algorithmus in einen Pornofilm. Das Tool TensorFlow, das dabei zum Einsatz kam, wurde 2015 von Google als Open-Source zu Verfügung gestellt, mit dem Ziel, maschinelles Lernen zu verbessern. Doch nun wird es missbraucht.

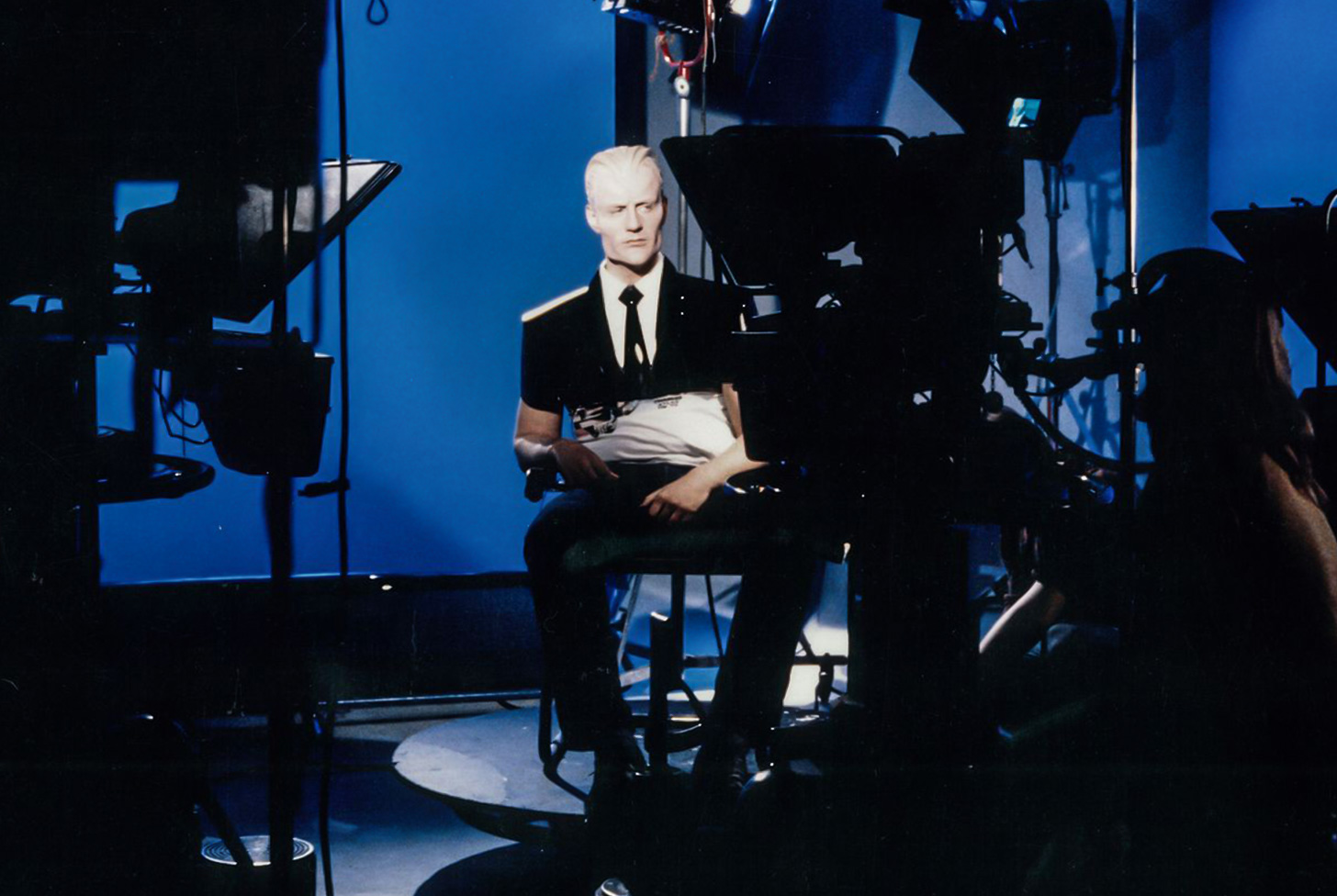

Wenn man sich den Clip genauer ansieht, erkennt man einige Unschärfen. Das Gesicht ist pixelig, der Kopf wirkt in manchen Szenen wie ein Fremdkörper. Es gibt bereits Techniken, mit denen sich Bildmaterial auch professionell manipulieren lässt. Forscher der Universität Erlangen haben eine Software entwickelt, mit der sich Mimik und Lippenbewegungen eines Menschen erfassen und in Echtzeit auf das Videobild einer anderen Figur übertragen zu lassen. Dabei wird das Gesicht des Sprechers aus drei Richtungen fotografiert. Ein Computerprogramm erstellt ein 3D-Modell, das wie eine Maske über das Konterfei einer anderen Person gelegt wird. Wenn die Person zu sprechen anfängt, übersetzt die Software simultan die Mimik und projiziert sie auf die Zielperson. Man kann also grinsen oder die Mundwinkel verziehen, während es der digitale Doppelgänger von Wladimir Putin gleichtut.

Auch Stimmen lassen sich verfälschen. Adobe hat im vergangenen Jahr eine Technik vorgestellt, mit der sich Sprachaufzeichnungen per Texteditor wie in einem Photoshop für Audioaufnahmen synthetisieren lassen. Mit dem Programm kann man Prominenten Worte in den Mund legen, die sie nie gesagt haben. Und es hört sich täuschend echt an. Forscher des chinesischen Suchmaschinenunternehmens Baidu haben kürzlich ein Klonverfahren entwickelt, das nur wenige Sekunden Ausgangsmaterial benötigt, um eine Stimme digital zu reproduzieren (Adobe brauchte dafür rund 20 Minuten Trainingsmaterial). Das mag ein wissenschaftlicher Fortschritt sein, doch im Hinblick auf stimmbiometrische Erkennungssysteme, die zunehmend im Bankensektor (etwa bei Online-Überweisungen) zum Einsatz kommen, ist das ein Problem. Stimmen, Bilder, Videos – mit der richtigen Software kann heutzutage alles manipuliert werden.

Was an dem Fake-Porno des Reddit-Nutzers verblüfft, ist zum einen die Leichtigkeit, mit der sich Bewegtbilder retuschieren lassen, zum anderen das immense Manipulationspotenzial. In Zeiten, in denen täglich 300 Millionen Fotos auf Facebook hochgeladen werden und an jeder Ecke Gesichtserkennungssysteme installiert werden, kann das Konterfei leichter Hand zum Gegenstand von Rachepornos werden. Kaum hat man sich versehen, landet man auf einer Pornoplattform oder sieht sich in kompromittierendem Videomaterial. Was die Frage aufwirft: Hat man noch die Kontrolle über sein eigenes Gesicht und über die eigene Stimme? Oder hat sich die digitale Datenflut so verselbständigt, dass jedes Schnipsel der Manipulation anheimfallen kann?

Der französische Medientheoretiker Jean Baudrillard schrieb in seinem Werk «Die Intelligenz des Bösen» (2004): «Man tritt in einen Bereich ein, wo die Ereignisse, durch ihre Produktion und Ausstrahlung in «Echtzeit», nicht mehr tatsächlich stattfinden – wo sie sich in der Leere der Information verlieren. Die Sphäre der Information ist wie ein Raum, in dem man, nachdem die Ereignisse ihrer Substanz entleert sind, erneut eine künstliche Schwere erschafft und sie wieder auf die Umlaufbahn in «Echtzeit» aussetzt – oder indem man sie, nachdem sie historisch entkräftet sind, auf die transpolitische Bühne der Information zurückwirft.»

Baudrillard schrieb bereits 2004 von «fake events» (sic!)– und als hätte er das Aufkommen von Deep Fakes geahnt: «Ob diese Ereignisse fabriziert sind oder nicht, so werden sie doch von der stillen Epidemie der Informationsnetzwerke inszeniert.» Man weiss gar nicht, was an der «Ereignisbörse» Internet noch real ist oder bereits durch irgendeine Software verfälscht wurde. Ist der Fake-Porno nicht insofern real, als er ein Artefakt darstellt und damit – zumindest in der Fälschung – authentisch ist? Oder ist er hyperreal, weil sich Fakt und Fiktion gar nicht mehr unterscheiden lassen? Das sind keine erkenntnistheoretischen Glasperlenspiele aus dem Elfenbeinturm, sondern Fragen von höchst praktischer Relevanz. Denn: An der Integrität der Information hängt auch die Integrität einer funktionierenden Öffentlichkeit. Ist Journalismus unter den Bedingungen der totalen Manipulation überhaupt noch möglich?

Natürlich kann man die Authentizität der Bilder anhand von Metadaten und der Zahl digitaler Bearbeitungsschritte verifizieren. Wenn ein Bild häufig bearbeitet wurde, legt dies nahe, dass es möglicherweise verfälscht wurde. Mit der Verbreitung von Fake-Videos erreicht die Manipulationstechnik aber eine neue Dimension, weil von Bewegtbildern und gesprochener Sprache eine ganz andere Wirkmacht als von Texten ausgeht. Die verleumderische Behauptung, Michelle Obama habe eine Vergangenheit als Pornodarstellerin, kann man leichter widerlegen als ein Fake-Porno. Ist ein Bild erstmal im Netz, lässt es sich schwerlich aus der Welt schaffen. Wir leben in einem Zeitalter der Hyperfaktizität, wo so viele Fakten existieren, dass man sich nach dem Baukastenprinzip seine eigene Version von Wahrheit zusammenbasteln kann. Das Problem ist nur, dass die Flut von Informationen die Kriterien objektiver Wahrheit auswäscht.